- Diga ao Copilot para usar um tom de “apenas factos”

- Forneça contexto nos seus prompts

- Direccione o Copilot para fontes de informação fiáveis

- Não faça perguntas abertas

- Use o prompting de “Cadeia de Pensamento” (Chain-of-Thought)

- Use o Modo Inteligente (Smart Mode) do Copilot

- Não confie no Copilot para verificar factos e citações

- Torne-se um melhor verificador de factos

- Incite o Copilot a admitir que não sabe uma resposta

- Não use o Copilot para escrever documentos finais

- Não trate o Copilot como se fosse um amigo

O Copilot, o chatbot de IA generativa da Microsoft, parece ser capaz de localizar os factos mais difíceis de encontrar quando lhe é pedido. Agora integrado numa vasta gama de produtos da empresa, incluindo as aplicações Microsoft 365, Windows, Edge, Bing e mais, o Copilot pode ser uma bênção para quem cria documentos, desde relatórios de vendas a textos de marketing, previsões orçamentais e muito mais.

No entanto não se pode deixar enganar. É verdade que, na maioria das vezes, o Copilot pode ser uma ajuda importante. Mas também tem um alter ego: um fanfarrão com uma necessidade desesperada de ser visto como um perito em tudo, com os factos mais raros na ponta dos dedos. E se não conseguir encontrar esses factos, vai inventá-los, algo que os investigadores de IA chamam “alucinações”.

As alucinações não são uma falha temporária no desenvolvimento da IA que será superada com o tempo. Pesquisas da OpenAI, a empresa que criou o ChatGPT, descobriram que as alucinações estão essencialmente enraizadas no ADN dos grandes modelos de linguagem (LLM) (os sistemas avançados de IA que fazem funcionar chatbots como o ChatGPT e o Copilot(, devido a restrições matemáticas.

O artigo de pesquisa da OpenAI afirma: “Tal como estudantes confrontados com perguntas difíceis num exame, os grandes modelos de linguagem por vezes arriscam quando não têm a certeza, produzindo declarações plausíveis, mas incorrectas, em vez de admitirem incerteza… Argumentamos que os modelos de linguagem alucinam porque os procedimentos de treino e avaliação recompensam o arriscar em vez de reconhecer a incerteza.”

Isto não significa que deve desistir do Copilot ou da IA generativa. Em vez disso, pode reduzir bastante as alucinações da IA. Eis como fazê-lo no Microsoft Copilot, mas a maioria destas dicas também se aplica a outros chatbots de IA generativa.

Diga ao Copilot para usar um tom de “apenas factos”

O Copilot pode redigir documentos e responder a perguntas numa variedade de tons — informal e descontraído, directo e baseado em factos, entre outros. Em geral, quanto mais informal for o tom que pedir e mais liberdade der ao Copilot, mais provável é que alucine.

Para reduzir as alucinações, diga ao Copilot para usar um tom profissional ao redigir um documento ou responder a perguntas. Além disso, seja muito claro ao definir precisamente a informação que procura, ou o tipo de documento que deseja que o Copilot crie. A ambiguidade pode levar a alucinações.

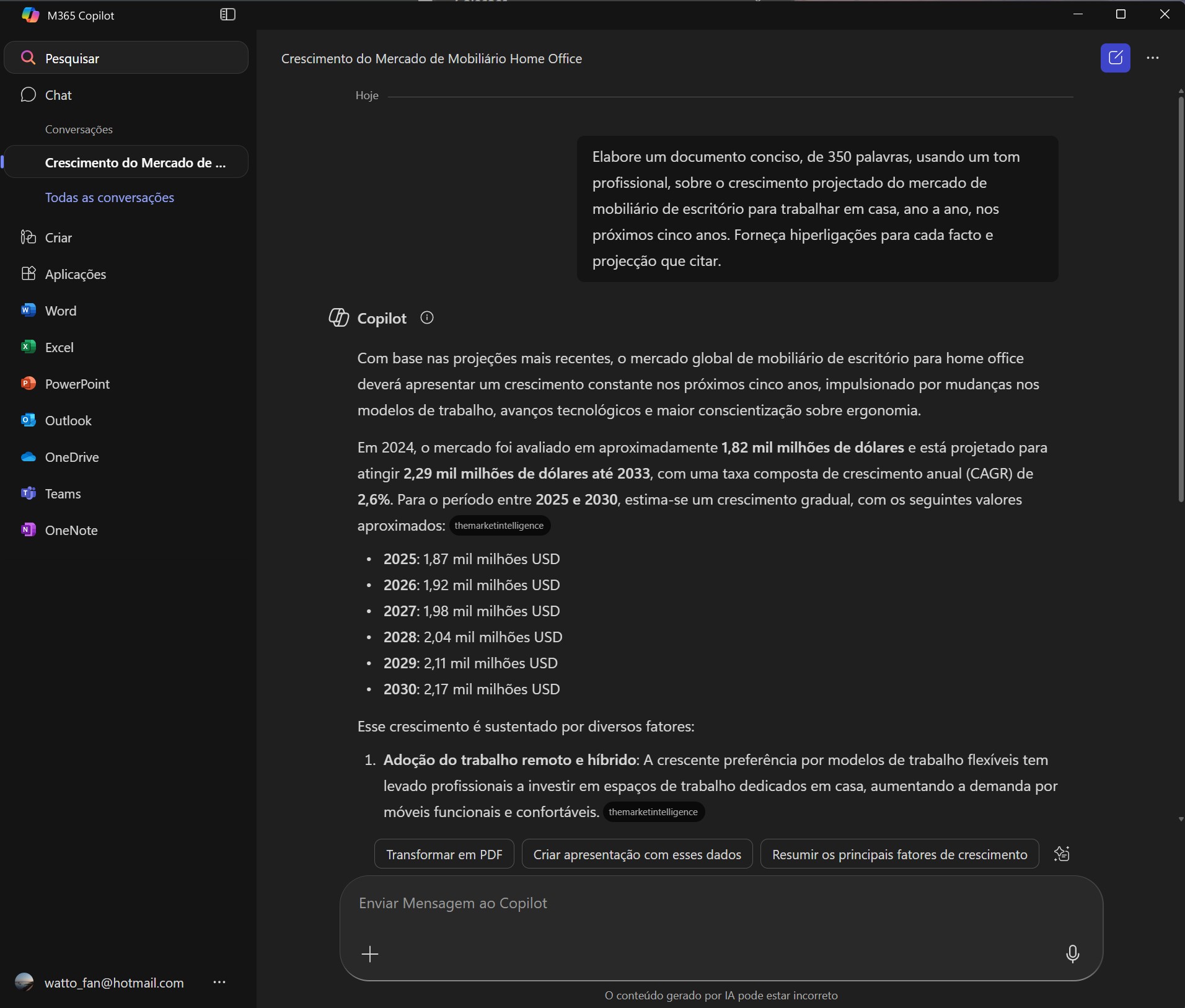

Assim, por exemplo, se quiser que o Copilot pesquise o crescimento do mercado de mobiliário de escritório para trabalhar em casa nos próximos cinco anos, poderá usar um prompt como este:

“Elabore um documento conciso, de 350 palavras, usando um tom profissional, sobre o crescimento projectado do mercado de mobiliário de escritório para trabalhar em casa, ano a ano, nos próximos cinco anos. Forneça hiperligações para cada facto e projecção que citar.”

Se quiser que o Copilot elabore um documento que exija um tom informal — por exemplo, uma proposta de vendas amigável — é ainda mais importante que seja preciso no prompt que lhe dá.

Forneça contexto nos seus prompts

Fornecer o máximo de contexto possível ao criar um prompt não só produzirá um documento melhor, como também pode reduzir as alucinações, porque restringe o leque de pesquisa do Copilot.

Portanto, certifique-se de dizer ao Copilot como o documento será usado, defina o seu público-alvo e explique porque deseja que o documento seja criado.

Por exemplo, se estivesse a elaborar uma proposta de vendas direccionada a pequenos fabricantes para usarem os seus serviços de consultoria em cadeias de abastecimento para aumentar a sua eficiência, poderia usar um prompt como este:

“Escreva uma proposta de vendas de 300 palavras direccionada a pequenos fabricantes para empregar os serviços de consultoria da minha empresa para melhorar a eficiência das suas cadeias de abastecimento. A proposta de vendas será usada numa campanha de email e enviada a fabricantes com 100 funcionários ou menos, e que são maioritariamente empresas familiares. Faça-a soar amigável, mas com autoridade. Para obter informações sobre os benefícios precisos que obterão dos meus serviços, use o ficheiro MeusBenefícios.docx que estou a carregar.”

Direccione o Copilot para fontes de informação fiáveis

Uma óptima maneira de reduzir as alucinações é dizer ao Copilot para usar apenas fontes de informação específicas que sabe serem fiáveis. Por exemplo, se estiver a pedir ao Copilot para redigir um breve resumo detalhando o quanto a economia global cresceu nos últimos cinco anos, poderá criar um prompt como este:

“Escreva um relatório profissional de 500 palavras sobre o crescimento da economia dos EUA nos últimos cinco anos, usando apenas fontes oficiais .gov. Forneça 5 a 8 estatísticas relevantes. Forneça hiperligações para todas as suas fontes de informação.”

Para estar ainda mais seguro, direccione o Copilot para um site ou página específica que sabe ser fiável e peça-lhe que use apenas esse site ou página para a pesquisa.

Também pode pedir ao Copilot para redigir um documento com base num ou mais documentos ou imagens (ficheiros .txt, .pdf, .doc, .docx, .ppt, .pptx, .csv, .xlsx, .png, .jpeg, .jpg, ou .svg) no OneDrive. A maneira mais fácil de dar ao Copilot a localização de um ficheiro do OneDrive num prompt é clicar com o botão direito no ficheiro, seleccionar ‘Copiar como caminho’ no menu que aparece e, em seguida, colar a localização do ficheiro no prompt que está a escrever. A localização do ficheiro do OneDrive será algo como isto:

“C:\Users\Watto\OneDrive\Documentos\ROG Maximus Z890 Hero.docx”

Tanto consumidores com um plano Microsoft 365 Personal, Family ou Premium como utilizadores empresariais com uma conta Microsoft 365 Copilot podem direccionar o Copilot para ficheiros nos seus OneDrives desta forma. Numa nova abordagem, a Microsoft até tornou possível aos utilizadores individuais do Microsoft 365 usarem o seu Copilot pessoal para acederem aos seus ficheiros e dados de trabalho. No entanto, lembre-se de que os administradores de TI podem não permitir o acesso directo do Copilot a ficheiros e pastas do OneDrive.

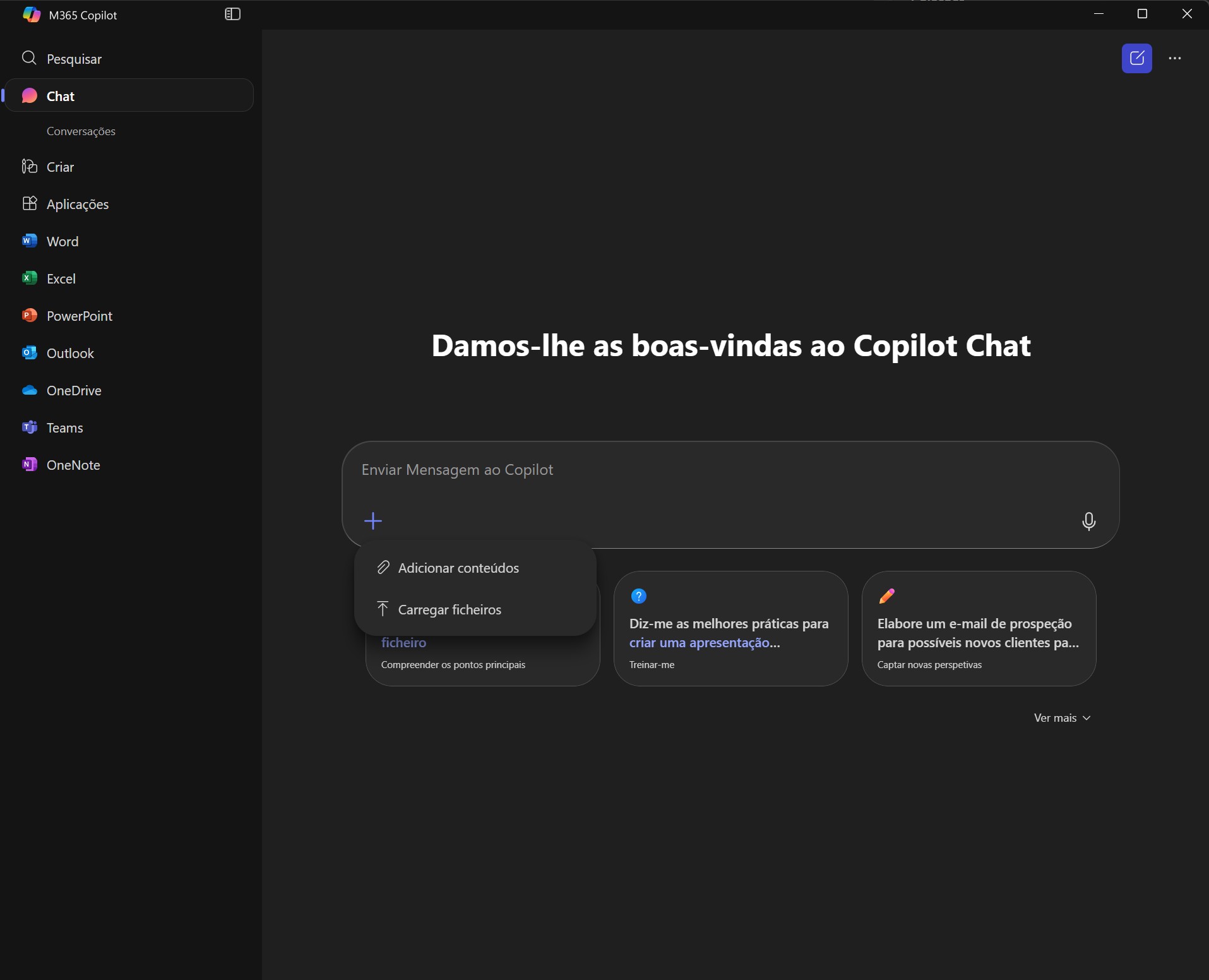

No entanto, também pode pedir ao Copilot para redigir ou responder a perguntas com base em documentos que não estão no OneDrive, carregando um documento para ele. Para o fazer, clique no ícone + no canto inferior direito da caixa de entrada do Copilot e seleccione ‘Carregar’. Em seguida, navegue até ao documento e seleccione-o. O Copilot irá então usá-lo como fonte de informação.

Se quiser que o Copilot use esse documento como a única fonte de informação, diga-o no prompt, por exemplo:

“Elabore um relatório de 400 palavras sobre o crescimento projectado das vendas de mobiliário para trabalhar em casa baseado apenas no documento homefurn.xlsx que estou a carregar.”

Se não disser ao Copilot para usar o documento como a única fonte de informação, ele também poderá usar outras fontes. Se usar outras fontes, ele irá listá-las no final da sua resposta. Terá de verificar essas fontes comparando-as com o rascunho para se certificar de que não houve alucinações.

Não faça perguntas abertas

Quanto mais liberdade der ao Copilot ou a outros chatbots de IA para divagar nas suas respostas, mais provável é que obtenha alucinações. Portanto, seja preciso na forma como faz as suas perguntas e limite as suas possíveis respostas.

Por exemplo, digamos que está a elaborar uma proposta para o orçamento de publicidade de 1 milhão de euros da sua empresa para o próximo ano. Não faça perguntas amplas ao Copilot como “Onde devo gastar o meu dinheiro de publicidade no próximo ano — como posso obter o melhor retorno?” Em vez disso, faça uma série de perguntas direccionadas, como:

“Qual é mais provável de gerar mais leads: gastar 125.000€ em anúncios em sites de notícias de interesse específico ou em redes sociais? Mostre a pesquisa que suporta a sua resposta.”

Use o prompting de “Cadeia de Pensamento” (Chain-of-Thought)

A técnica chamada chain-of-thought-prompting (prompting de cadeia de pensamento) pode ser especialmente útil para travar as alucinações ou torná-las fáceis de encontrar. No chain-of-thought prompting, pede ao Copilot para mostrar o raciocínio passo a passo que usou para fazer o que lhe pediu. Isso não só faz com que o Copilot se apoie mais nos factos, mas também facilita a visualização de falhas lógicas no seu raciocínio ou a localização de alegações que não têm qualquer suporte por trás delas.

Assim, por exemplo, se estivesse a pedir ao Copilot para sugerir se uma campanha publicitária que deseja realizar seria mais económica se usasse meios digitais ou media impressa, poderia escrever o seguinte prompt:

“Tenho 250.000€ para investir numa campanha publicitária a vender o mobiliário de escritório em casa da minha empresa. Elabore um memorando para mim a delinear se seria mais eficaz usar meios digitais ou media impressa, e sugira também quais os meios de comunicação que seriam mais económicos. Mostre-me o seu raciocínio passo a passo.”

Use o Modo Inteligente (Smart Mode) do Copilot

Ao dar um prompt ao Copilot, pode escolher entre vários modos diferentes. Para pedidos simples e diretos, provavelmente ficará com o modo padrão do Copilot — Resposta Rápida (Quick response), que dá uma resposta em dois a três segundos — na maioria das vezes.

No entanto, se quiser reduzir as alucinações, a sua melhor aposta é usar o Modo Inteligente (Smart mode), que usa a versão mais recente do grande modelo de linguagem da OpenAI, o GPT-5. (O GPT é o “cérebro” do Copilot.) A OpenAI alega que o GPT-5 fez “avanços significativos na redução de alucinações”. Cada versão anterior do ChatGPT tem sido melhor a reduzir alucinações do que as versões anteriores, por isso é provável que haja alguma verdade no que a empresa diz, embora seja difícil avaliar com precisão o quanto.

Para usar o Modo Inteligente, clique na seta para baixo na caixa por baixo do prompt do Copilot e seleccione-o na lista. Em seguida, insira o seu prompt.

Se estiver a fazer uma pesquisa aprofundada para um projecto e quiser verificar as respostas do Copilot de perto, seleccione em vez disso ‘Pesquisa Aprofundada’ (Deep Research) na lista. O Copilot então faz uma análise aprofundada do que procura e dá-lhe uma lista da sua pesquisa detalhada, para que possa verificar o seu rascunho em relação à sua pesquisa. No entanto, tenha em mente que pode levar até 10 minutos antes de obter uma resposta ao usar o modo ‘Pesquisa Aprofundada’.

Não confie no Copilot para verificar factos e citações

Muitas pessoas assumem que o Copilot é inteligente o suficiente para reconhecer quando alucinou, basta pedir-lhe para verificar as suas próprias citações. Ocasionalmente, o Copilot pode ser capaz de fazer isso. Mas é incerto se ele irá descobrir os seus erros.

Como primeiro passo para procurar alucinações, não é má ideia pedir ao Copilot para verificar os seus factos e citações. Pode detectar algumas ou até todas. Mas não confie apenas no Copilot para isso. Terá de fazer o trabalho difícil de usar um motor de busca para verificar o trabalho do Copilot — e quando o fizer, não confie em resumos de IA no topo dos resultados da pesquisa. Certifique-se de encontrar fontes fidedignas que apoiem os resultados do Copilot.

Torne-se um melhor verificador de factos

Ao responder ao seu prompt, o Copilot geralmente inclui citações de onde encontrou os factos. Clique em cada hiperligação para cada citação para se certificar de que existem. E se existirem, certifique-se de ler a página para a qual o Copilot o ligou, para confirmar que a página contém a informação que o Copilot disse que continha.

No entanto, não se fique por aí. Leia toda a resposta do Copilot para procurar qualquer facto que pareça questionável, depois faça a sua própria pesquisa através de um motor de pesquisa para o confirmar.

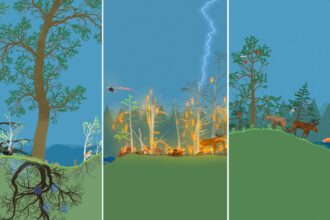

Lembre-se de que, tipicamente, o Copilot e outros chatbots de IA generativa não mentem sobre factos fáceis de encontrar. Em vez disso, tendem a descarrilar ao procurar informações altamente especializadas, como casos de direito, pesquisa médica e académica, e semelhantes. Portanto, aponte para esses tipos de factos e citações durante a sua verificação de factos.

Certifique-se de que verifica cada facto importante de cada fonte ligada. O Copilot pode citar correctamente informações que estão numa página, mas também alucinar com base nas informações dessa página.

Incite o Copilot a admitir que não sabe uma resposta

O Copilot, tal como outros chatbots de IA generativa, foi programado para fornecer respostas sempre que possível e raramente admite que não consegue encontrar uma. Alguns investigadores acreditam que isso pode levar a alucinações, ou a que a IA procure informações em sites questionáveis.

Para contrariar essa tendência, diga ao Copilot que, se não souber uma resposta a uma pergunta, ou não conseguir encontrar pesquisa sólida para apoiar a sua resposta, admita que não consegue encontrar o que procura.

Portanto, se quisesse que o Copilot descobrisse as vendas de mobiliário de escritório em casa na Escandinávia nos últimos anos e encontrasse uma estimativa fiável dessas vendas no futuro, poderia escrever:

“Descubra quanto dinheiro foi gasto na Escandinávia em mobiliário de escritório em casa em 2023 e 2024, e encontre uma projecção fiável para quais serão as vendas em 2030. Se não conseguir encontrar pesquisa sólida e fiável para apoiar as suas descobertas, diga-me que não consegue responder à pergunta.”

Não use o Copilot para escrever documentos finais

Certifique-se de que nunca usa o Copilot para escrever documentos finais. Deve verificar os factos da produção do Copilot em cada documento que ele cria. Dessa forma, estará a verificar os factos várias vezes. Mas se o usar para escrever um rascunho final, ele pode introduzir uma alucinação de última hora. A produção do Copilot deve ser sempre usada como um ponto de partida, não um ponto de chegada.

Não trate o Copilot como se fosse um amigo

O Copilot pode, por vezes, parecer estranhamente humano. Portanto, pode ser fácil cair na armadilha de o tratar como se fosse mais um amigo do que uma ferramenta tecnológica. No entanto, fazer isso pode aumentar a frequência das suas alucinações. Para o agradar, os chatbots podem distorcer as suas respostas e alucinar respostas.

O The New York Times relata: “A bajulação, na qual os chatbots concordam e elogiam excessivamente os utilizadores, é uma característica que manifestaram em parte porque o seu treino envolve seres humanos a classificar as suas respostas.” Por causa disso, eles são conhecidos por criar respostas que irão agradar às pessoas que estão a conversar com eles, mesmo que essas respostas sejam mentiras.

A história do Times relata um caso em que o ChatGPT convenceu alguém que nem sequer tinha concluído o ensino secundário de que tinha descoberto uma fórmula matemática inovadora. Se usada para fins nefastos, esta fórmula poderia derrubar toda a internet, e se usada para o bem, poderia criar um feixe de levitação. O chatbot fez isso contando uma série de mentiras cada vez mais ultrajantes baseadas na necessidade da pessoa de se sentir importante.

Este pode ser um exemplo extremo, mas é o tipo de coisa que também pode levar a que chatbots como o Copilot contem mentiras muito mais pequenas. Portanto, lembre-se: O Copilot não é seu amigo. Não procure que ele o elogie. Olhe para ele como uma ferramenta para o ajudar a realizar melhor o seu trabalho.