Quando os geradores de imagens por IA surgiram, a desinformação tornou-se imediatamente uma grande preocupação. Embora a exposição repetida a imagens geradas por IA possa criar alguma resistência, um estudo recente da Microsoft sugere que certos tipos de imagens reais e falsas conseguem ainda enganar muita gente.

O estudo concluiu que os humanos conseguem distinguir com precisão fotografias reais de imagens geradas por IA cerca de 63% das vezes. Em contraste, a ferramenta de detecção de IA da Microsoft, que está em desenvolvimento, alegadamente tem uma taxa de sucesso de 95%.

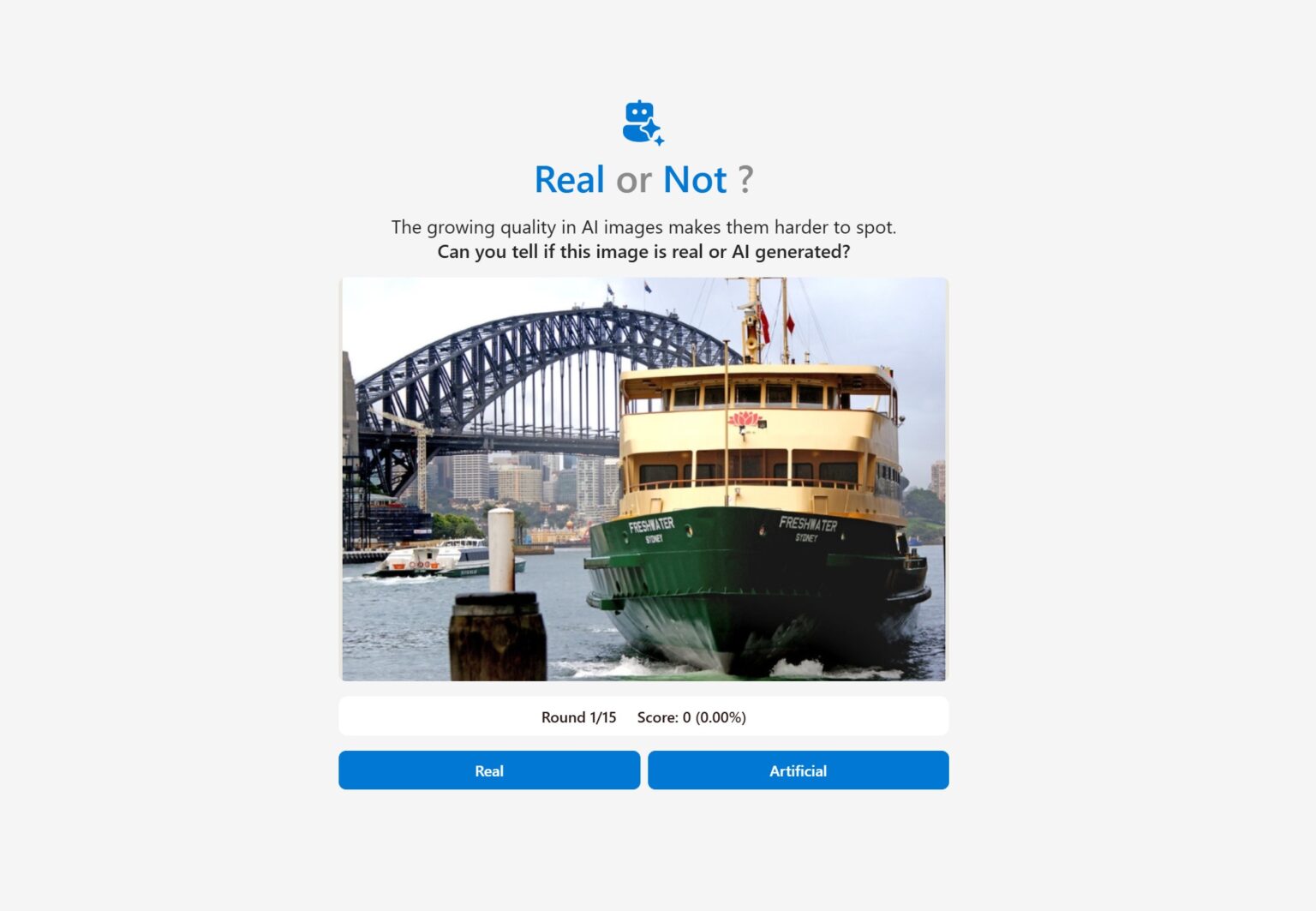

Para aprofundar esta questão, a Microsoft criou um questionário online (realornotquiz.com) com 15 imagens seleccionadas aleatoriamente a partir de bibliotecas de fotos de arquivo e criadas através de vários modelos de IA. O estudo analisou 287.000 imagens visualizadas por 12.500 participantes de todo o mundo.

Os participantes tiveram mais sucesso na identificação de imagens de pessoas geradas por IA, com uma taxa de precisão de 65%. No entanto, as imagens falsas mais convincentes foram deepfakes GAN que mostravam apenas perfis faciais ou usavam inpainting para inserir elementos gerados por IA em fotos reais.

Apesar de serem uma das formas mais antigas de de gerar imagens por IA, os deepfakes GAN (Generative Adversarial Networks) ainda enganaram cerca de 55% dos espectadores. Isto deve-se, em parte, ao facto de conterem menos detalhes que os geradores de imagem normalmente têm dificuldade em replicar. Ironicamente, a sua semelhança com fotografias de baixa qualidade torna-as frequentemente mais credíveis.

Os investigadores acreditam que a crescente popularidade dos geradores de imagens tornou os espectadores mais familiarizados com a estética excessivamente suave que estas ferramentas produzem. Solicitar à IA que imite a fotografia autêntica pode ajudar a reduzir este efeito.

Alguns utilizadores descobriram que incluir nomes genéricos de ficheiros de imagem nos prompts produzia resultados mais realistas. Mesmo assim, a maioria destas imagens ainda se assemelha a fotos polidas, com qualidade de estúdio, o que pode parecer deslocado em contextos casuais ou espontâneos. Em contraste, alguns exemplos do estudo da Microsoft mostram que o Flux Pro consegue replicar a fotografia amadora, produzindo imagens que parecem ter sido tiradas com uma câmara de um smartphone comum.

Os participantes tiveram ligeiramente menos sucesso na identificação de imagens geradas por IA de paisagens naturais ou urbanas que não incluíam pessoas. Por exemplo, as duas imagens falsas com as taxas de identificação mais baixas (21% e 23%) foram geradas usando prompts que incorporavam fotografias reais para guiar a composição. As imagens de IA mais convincentes também mantiveram níveis de ruído, brilho e entropia semelhantes aos encontrados em fotos reais.

Surpreendentemente, as três imagens com as taxas de identificação mais baixas no geral: 12%, 14% e 18%, eram, na verdade, fotografias reais que os participantes identificaram erradamente como falsas. As três mostravam os militares dos EUA em cenários incomuns com iluminação, cores e velocidades de obturador invulgares.

A Microsoft diz que que compreender quais os prompts mais propensos a enganar os espectadores pode tornar a desinformação futura ainda mais persuasiva. A empresa destaca o estudo como um lembrete da importância da rotulagem clara para imagens geradas por IA.