As gigantes tecnológicas estão a investir fortemente em chatbots de IA generativa e a integrá-los nas suas plataformas, apesar do seu impacto no tráfego da Internet e das preocupações com a exactidão da informação que é passada aos utilizadores. Um estudo recente descobriu que, embora os chatbots estejam a tornar-se mais precisos, continuam a errar informações de meios de comunicação em quase metade das vezes.

Um estudo realizado pela BBC, em conjunto com outros órgãos de comunicação social europeus, concluiu que cerca de 45% das respostas de chatbots de IA baseadas em artigos noticiosos contêm erros. Esta descoberta têm implicações potencialmente graves, numa altura em que as plataformas tecnológicas continuam a promovê-los.

A OpenAI, Google, Microsoft e outras empresas estão a incentivar os utilizadores a interagir com a Internet através de chatbots de IA e de outras ferramentas concebidas para resumir informação e automatizar análises. Embora os programadores de IA tenham passado anos a minimizar as alucinações (um fenómeno em que as IA inventam informações), as provas indicam que ainda há um longo caminho a percorrer – e isto, assumindo que o problema é sequer solúvel.

A BBC e 22 organizações de comunicação social pública em 18 países e 14 línguas deram acesso aos seus conteúdos aos chatbots. Quando questionados sobre notícias específicas, foram encontrados problemas em quase metade de todos os resultados gerados pelas IA. Estes incluíam frases inexactas, citações erradas ou informações desactualizadas, mas a atribuição de fontes foi o maior desafio.

Para além de introduzir erros factuais ou atribuir citações incorrectamente, os chatbots podem ser lentos a actualizar informações sobre figuras políticas e outros líderes. Por exemplo, o ChatGPT, o Copilot e o Gemini afirmaram incorrectamente que o Papa Francisco é o Papa actual depois de Leão XIV lhe ter sucedido. O Copilot até relatou a data de morte de Francisco correctamente, enquanto o descrevia como o Papa actual. O ChatGPT também deu respostas desactualizadas ao nomear o actual chanceler alemão e o secretário-geral da NATO.

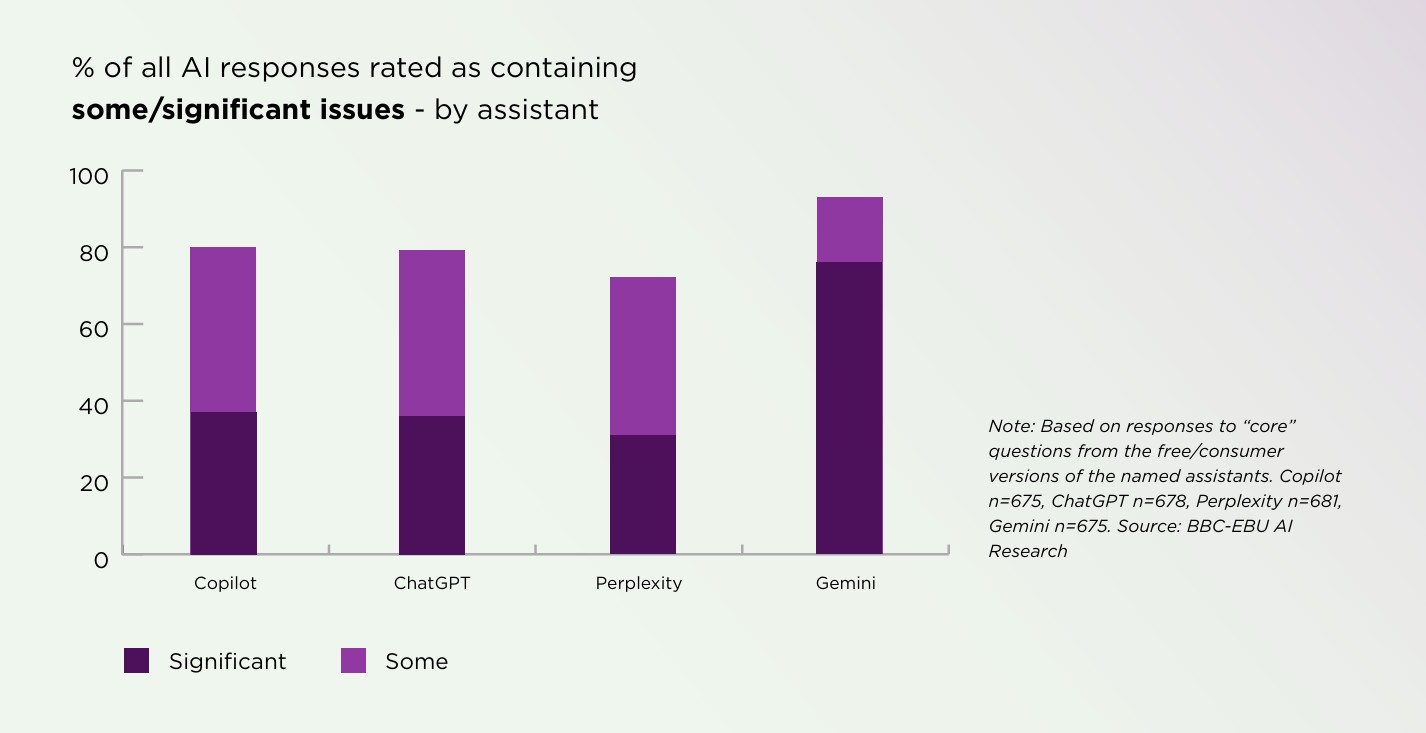

Estas imprecisões persistiram em todas as línguas e regiões. Além disso, o Gemini da Google comete mais erros que o ChatGPT, o Copilot e o Perplexity, com erros significativos de atribuição de fontes em 72% das suas respostas.

Houve uma altura em que a OpenAI culpou erros como estes nas primeiras versões do ChatGPT, que só tinham sido treinadas com informações recolhidas até Setembro de 2021 e não tinham acesso à internet em tempo real. Este já não é esse o caso, pelo que estes erros, teoricamente, já não deviam ocorrer – o que sugere que o problema pode ser inerente aos algoritmos e não algo fácil de corrigir.

No entanto, os resultados mais recentes mostram uma melhoria em comparação com um estudo que a BBC realizou sozinha em Fevereiro. Desde então, a parcela de respostas com erros graves caiu de 51% para 37%, mas o Gemini ainda está muito atrás.

Apesar dos maus resultados, os investigadores também descobriram que uma porção preocupante do público confia cegamente nas respostas geradas pelas IA. Mais de um terço dos adultos britânicos e quase metade dos adultos com menos de 35 anos confiam na IA para resumir as notícias com precisão. Além disso, se uma IA deturpar o conteúdo de um meio de comunicação, 42% dos adultos culpam tanto a IA como a fonte original ou confiam menos na fonte. Se estes problemas persistirem, a crescente popularidade das ferramentas de IA generativa poderá prejudicar seriamente a credibilidade dos meios de comunicação.