Se passa sequer um pouco de tempo online, é provável que já tenha visto uma imagem ou um vídeo gerado por Inteligência Artificial (IA). E todos já fomos enganados por vídeos gerados por IA que são mais ou menos credíveis. Mas o Sora e o Veo da Google estão a levar os vídeos de IA a um nível totalmente novo, tornando mais importante do que nunca saber como identificar imagens geradas por IA.

O Sora é a aplicação “irmã” da ChatGPT, feita pela mesma empresa-mãe, a OpenAI. O nome deriva do gerador de vídeo de IA, lançado em 2024. Mas recentemente sofreu uma grande actualização com um novo modelo Sora 2, juntamente com uma nova aplicação de redes sociais com o mesmo nome. A aplicação, semelhante ao TikTok, tornou-se viral, com entusiastas de IA determinados a tentar arranjar códigos de convite para a poder usar. Mas não é como qualquer outra plataforma de redes sociais. Tudo o que vê na Sora é falso; todos os vídeos são gerados por IA. Usar o Sora é um pesadelo de deepfakes: inócuo à primeira vista, com riscos perigosos à espreita, logo abaixo da superfície.

De um ponto de vista técnico, os vídeos gerados pelo Sora são impressionantes em comparação com os concorrentes como o V1 da Midjourney e o Veo 3 da Google. Os vídeos Sora têm alta resolução, áudio sincronizado e criatividade surpreendente. A funcionalidade mais popular da Sora, apelidada de “cameo”, permite usar a imagem de outras pessoas e inseri-las em quase todas as cenas geradas por IA. É uma ferramenta impressionante, resultando em vídeos assustadoramente realistas.

É por isso que tantos especialistas estão preocupados com o Sora, que pode tornar mais fácil do que nunca para qualquer pessoa criar deepfakes, espalhar desinformação e esbater a linha entre o que é real e o que não é.

Identificar conteúdo de IA é um desafio contínuo para as empresas de tecnologia, plataformas de redes sociais e todos nós que as usamos. Mas nem tudo está perdido. Aqui estão algumas pistas a observar para identificar se um vídeo foi feito usando IA.

Procure a Marca de Água

Todos os vídeos feitos na aplicação Sora para iOS (ou em qualquer outra plataforma do género) incluem uma marca de água quando os descarrega. É o logótipo branco da Sora – um ícone de nuvem – que salta pelas extremidades do vídeo. É semelhante à forma como os vídeos do TikTok são marcados.

A marca de água no conteúdo é uma das principais formas como as empresas de IA podem ajudar-nos visualmente a detectar conteúdo gerado por IA. O modelo “nano banana” do Gemini da Google, por exemplo, marca automaticamente as imagens. As marcas de água são óptimas porque servem como um sinal claro de que o conteúdo foi feito com a ajuda da IA.

Mas as marcas de água não são perfeitas. Por um lado, se a marca de água for estática (não se mover), pode ser facilmente cortada. Mesmo para marcas de água em movimento como a da Sora, existem aplicações concebidas especificamente para as remover, pelo que as marcas de água sozinhas não podem ser totalmente fiáveis. Quando o CEO da OpenAI, Sam Altman, foi questionado sobre isto, disse que a sociedade terá de se adaptar a um mundo onde qualquer pessoa pode criar vídeos falsos de qualquer um. É claro que, antes do Sora da OpenAI, não havia uma forma popular, facilmente acessível e que não exigisse qualquer competência para fazer esses vídeos. Mas o argumento levanta um ponto válido sobre a necessidade de confiar noutros métodos para verificar a autenticidade.

Verifique os metadados

Provavelmente está a pensar que não há hipótese de verificar os metadados de um vídeo para determinar se é real. Mas é uma óptima maneira de determinar se um vídeo foi feito com recurso a IA, e é mais fácil de fazer do que pensa.

Os metadados são um conjunto de informações anexadas automaticamente a uma peça de conteúdo quando é criada. Dão-lhe mais detalhes sobre como uma imagem ou vídeo foi criado. Pode incluir o tipo de câmara usada para tirar uma fotografia, a localização, data e hora em que um vídeo foi captado e o nome do ficheiro. Cada fotografia e vídeo têm metadados, independentemente de terem sido criados por humanos ou por IA. E muito conteúdo criado por IA também terá credenciais de conteúdo que denotam as suas origens.

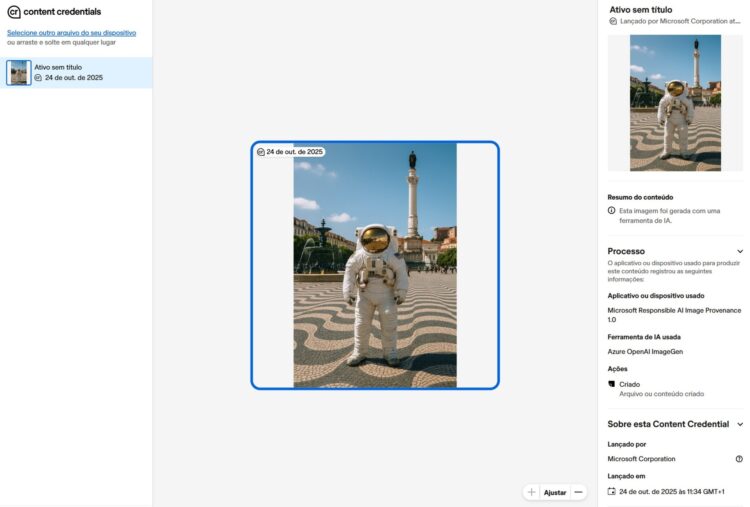

A OpenAI faz parte da Coalition for Content Provenance and Authenticity (C2PA), o que significa que os vídeos Sora incluem metadados C2PA. Pode usar a ferramenta de verificação da Content Authenticity Initiative para verificar os metadados de um vídeo, imagem ou documento. Veja como. (A Content Authenticity Initiative faz parte da C2PA.)

Como verificar os metadados de uma foto, vídeo ou documento:

- Aceda a este URL: https://verify.contentauthenticity.org/

- Carregue o ficheiro que pretende verificar.

- Clique em Open (Abrir).

- Verifique as informações no painel do lado direito. Se for gerado por IA, deverá incluir essa informação na secção de resumo do conteúdo.

Quando passa um vídeo gerado no Sora por esta ferramenta, esta dirá que o vídeo foi “emitido pela OpenAI” e incluirá o facto de ser gerado por IA. Todos os vídeos Sora devem conter estas credenciais que lhe permitem confirmar que foi criado com a Sora.

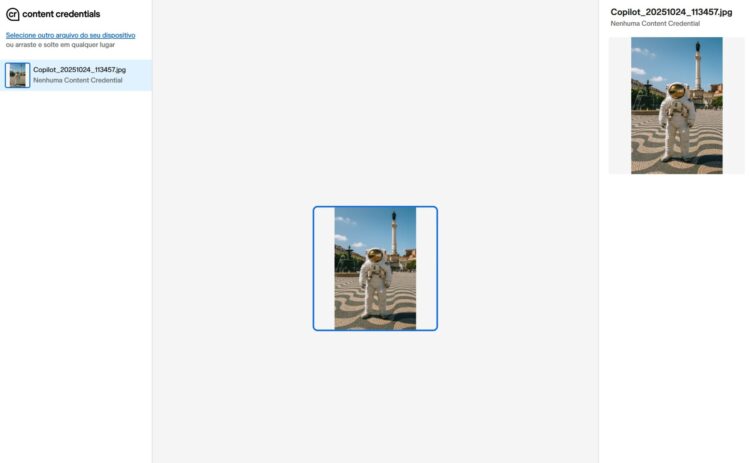

Esta ferramenta, como todos os detectores de IA, não é perfeita. Existem muitas maneiras de os vídeos de IA evitarem a detecção. Se tiver outros vídeos que não sejam Sora, estes podem não conter os sinais necessários nos metadados para que a ferramenta determine se são ou não criados por IA. Os vídeos de IA feitos com a Midjourney, por exemplo, não são sinalizados. Mesmo que o vídeo tenha sido criado no Sora, mas depois passado por uma aplicação de terceiros (como uma de remoção de marcas de água) e descarregado novamente, isso torna menos provável que a ferramenta o sinalize como IA.

Por exemplo, se abrir uma imagem gerada por IA na aplicação Fotografias do Windows e voltar a gravá-la num formato diferente, os metadados são apagados, ou pelo menos deixam de ser detectados por esta ferramenta.

Procure outras informações de IA e inclua as suas

Se estiver numa das plataformas de redes sociais da Meta, como o Instagram ou o Facebook, pode ter uma pequena ajuda para determinar se algo é gerado por IA. A Meta tem sistemas internos para ajudar a sinalizar conteúdo de IA e rotulá-lo como tal. Estes sistemas não são perfeitos, mas pode ver claramente a etiqueta para publicações que foram sinalizadas. O TikTok e o YouTube têm políticas semelhantes para rotular conteúdo de IA.

A única maneira verdadeiramente fiável de saber se algo é gerado por IA é se o criador o divulgar. Muitas plataformas de redes sociais oferecem agora definições que permitem aos utilizadores rotular as suas publicações como geradas por IA. Mesmo um simples crédito ou divulgação na sua legenda pode ser muito útil para ajudar todos a entenderem como algo foi criado.

Enquanto está a navegar no Sora, sabe que nada é real. Mas, assim que sai da aplicação e partilha vídeos gerados por IA, é nossa responsabilidade colectiva divulgar como um vídeo foi criado. À medida que modelos de IA como o Sora continuam a esbater a linha entre a realidade e a IA, cabe-nos a todos nós tornar o mais claro possível quando algo é real ou IA.

Mantenha-se vigilante

Não há um método infalível para distinguir com precisão, a um único olhar, se um vídeo é real ou IA. A melhor coisa que pode fazer para evitar ser enganado é não acreditar automática e inquestionavelmente em tudo o que vê online. Siga a sua intuição – se algo parece irreal, provavelmente é. Nestes tempos sem precedentes, cheios de “lixo” de IA, a sua melhor defesa é inspeccionar de perto os vídeos que está a ver. Não se limite a olhar rapidamente e a deslizar sem pensar. Verifique se há texto distorcido, objectos a desaparecer e movimentos que desafiam a física. E não se recrimine se for enganado ocasionalmente; até os especialistas se enganam.