Disponível já em mais de duzentos jogos, a DLSS é o que se pode chamar de um verdadeiro “acto de magia” ou um autêntico “milagre tecnológico”. Esta tecnologia permite pegar em elementos da imagem, especialmente aqueles que surgem de forma estática, ao longo de vários fotogramas, e fazer um processo de upscaling, que por sua vez é readaptado para a resolução nativa do jogo. Ou seja, memoriza-os, para que possam ser posteriormente reaproveitados nos fotogramas seguintes.

O facto de usar um método de upscaling, em conjunto com anti-aliasing, elimina o potencial aparecimento de falhas na imagem e de artefactos. Todavia, a sua implementação, na versão original, era bastante exigente, e implicava alteração no código-fonte do próprio jogo; além disto, os núcleos Tensor das GeForce RTX tinham de aprender por si próprias a aplicar o DLSS em cada jogo.

Ultra Performance para chegar aos 8K

Com a chegada da segunda geração do DLSS, todo o trabalho de aprendizagem passou a ser desempenhado pelos supercomputadores da Nvidia, sendo toda a informação disponibilizada por redes neurais proprietárias. Isto permitiu uma reorganização na forma de actuar dos núcleos Tensor. Acabaram-se, assim, as limitações do DLSS original, que passou a disponibilizar três modos de utilização: Quality (upscaling de 2x), Balanced (3x) e Performance (4x). O DLSS 2.1 introduziu ainda o modo ‘Ultra Performance’, com upscaling de 9x, essencial para que a GeForce RTX 3090 lidasse com jogos 8K. Contudo, este modo aumentava significativamente a probabilidade do aparecimento de artefactos no ecrã, tornando assim pouco recomendável a sua utilização.

Cyberpunk a 130 fps com DLSS 3.0

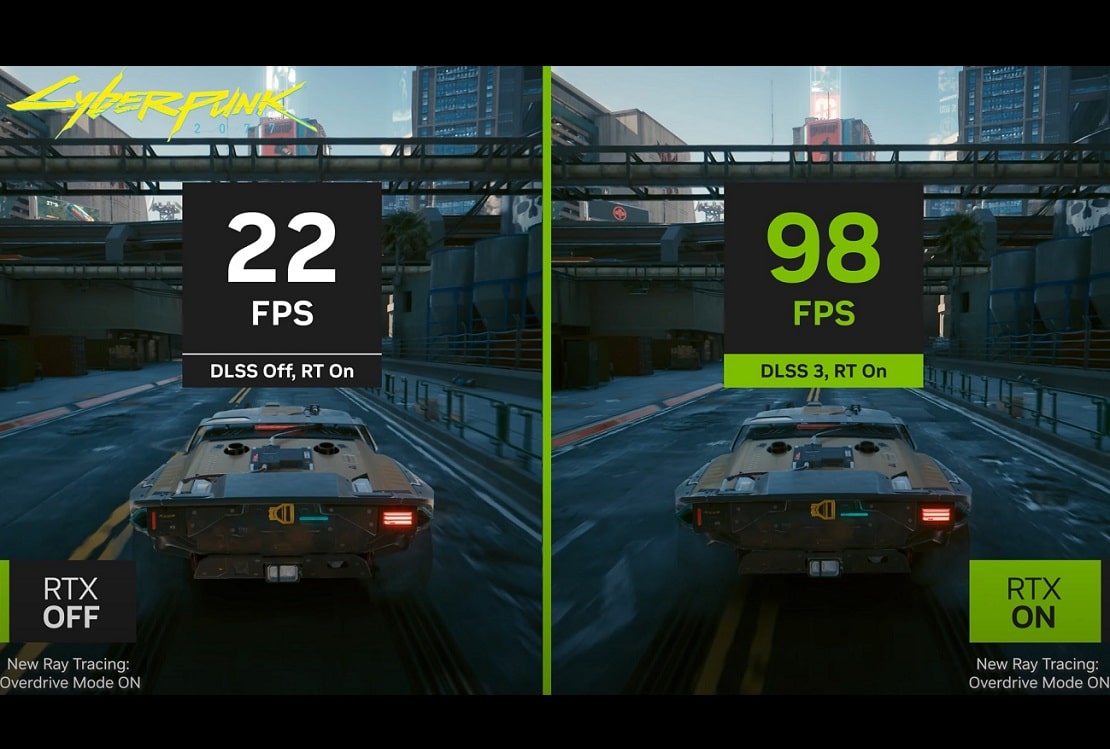

Com a chegada da GeForce RTX 4090, a Nvidia introduziu o DLSS 3.0, que permitiu a introdução de um fotograma totalmente gerado por IA, entre dois reais. Esta técnica permite, em certos casos, triplicar o desempenho do sistema – por exemplo, em Cyberpunk 2077, com resolução 4K e Ray Tracing ligado, usar DLSS 2.0 faz o jogo chegar aos 90 fps; já com DLSS 3.0, o valor máximo é de 130 fps. Em comparação, com DLSS, são apenas 40 fps.

Isto significa que, embora a velocidade da imagem reproduzida no monitor seja muito superior ao habitual, os núcleos Tensor têm de “receber” o resultado do fotograma final completamente renderizado pela GPU.

Desta forma, passa a existir uma maior latência no sistema, pois as imagens (tanto real, como virtual) têm de ser geradas, em primeiro lugar, pelo sistema, e só depois reproduzidas no monitor. A probabilidade de aparecimento de falhas e artefactos no ecrã também aumentou, mas será uma questão de tempo até que a tecnologia amadureça e torne este processo cada vez mais eficaz e interessante.